HDFS 文件读写流程

前言

HDFS 读写流程都搞不明白还混个球啊

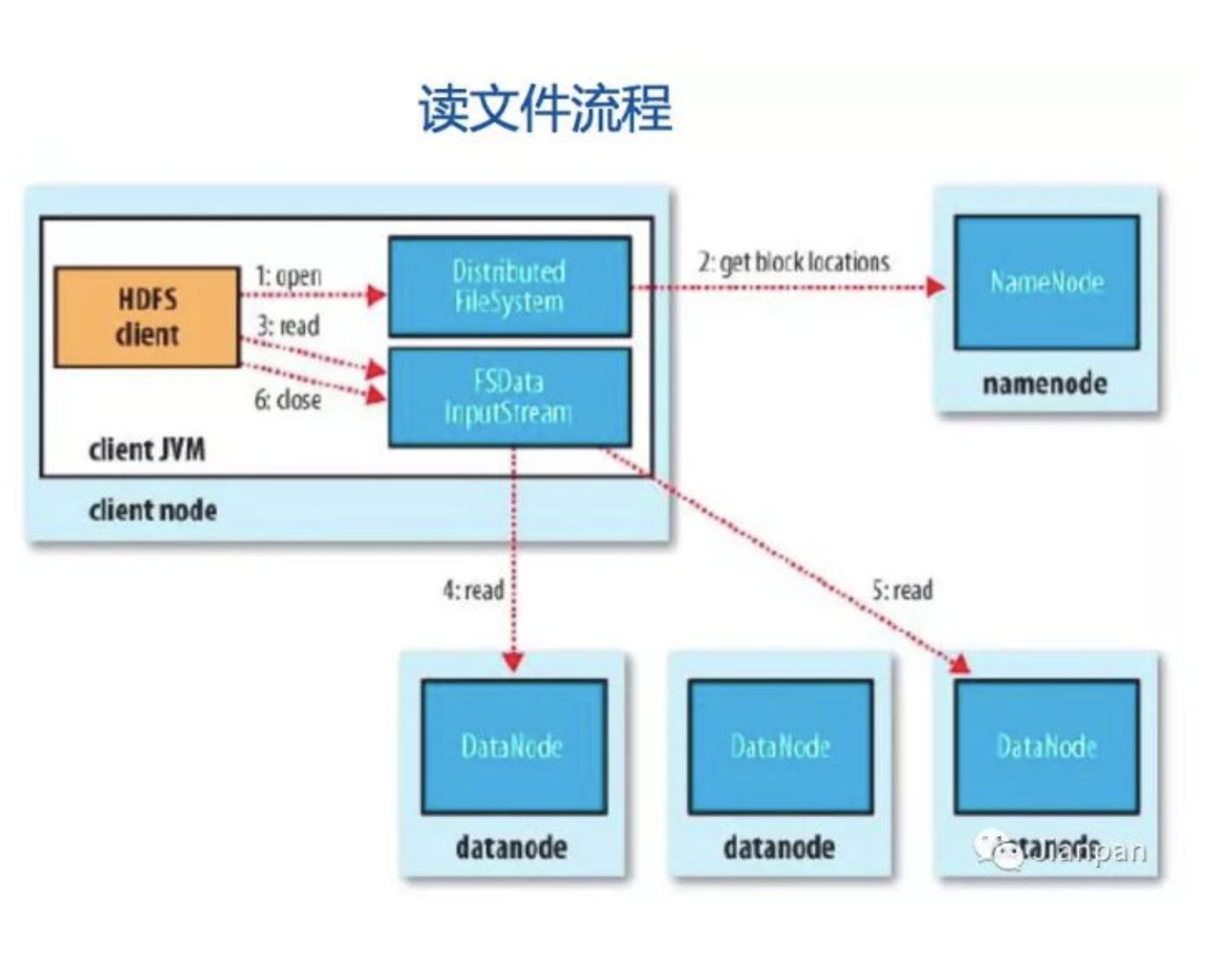

读文件的流程

如图所示,读文件的流程主要包括以下6个步骤:

- 打开分布式文件:调用分布式文件 DistributedFileSystem.open( ) 方法;

- 寻址请求:从 NameNode 处得到 DataNode 的地址,DistributedFileSystem使用 RPC 方式调用了NameNode,NameNode 返回存有该副本的DataNode 地址,DistributedFileSystem 返回了一个输入流对象(FSDataInputStream),该对象封装了输入流 DFSInputStream;

- 连接到DataNode:调用输入流 FSDataInputStream.read( ) 方法从而让DFSInputStream 连接到 DataNodes;

- 从 DataNode 中获取数据:通过循环调用 read( ) 方法,从而将数据从 DataNode 传输到客户端;

- 读取另外的 DataNode 直到完成:到达块的末端时候,输入流 DFSInputStream 关闭与 DataNode 连接, 寻找下一个 DataNode;

- 完成读取,关闭连接:即调用输入流 FSDataInputStream.close( );

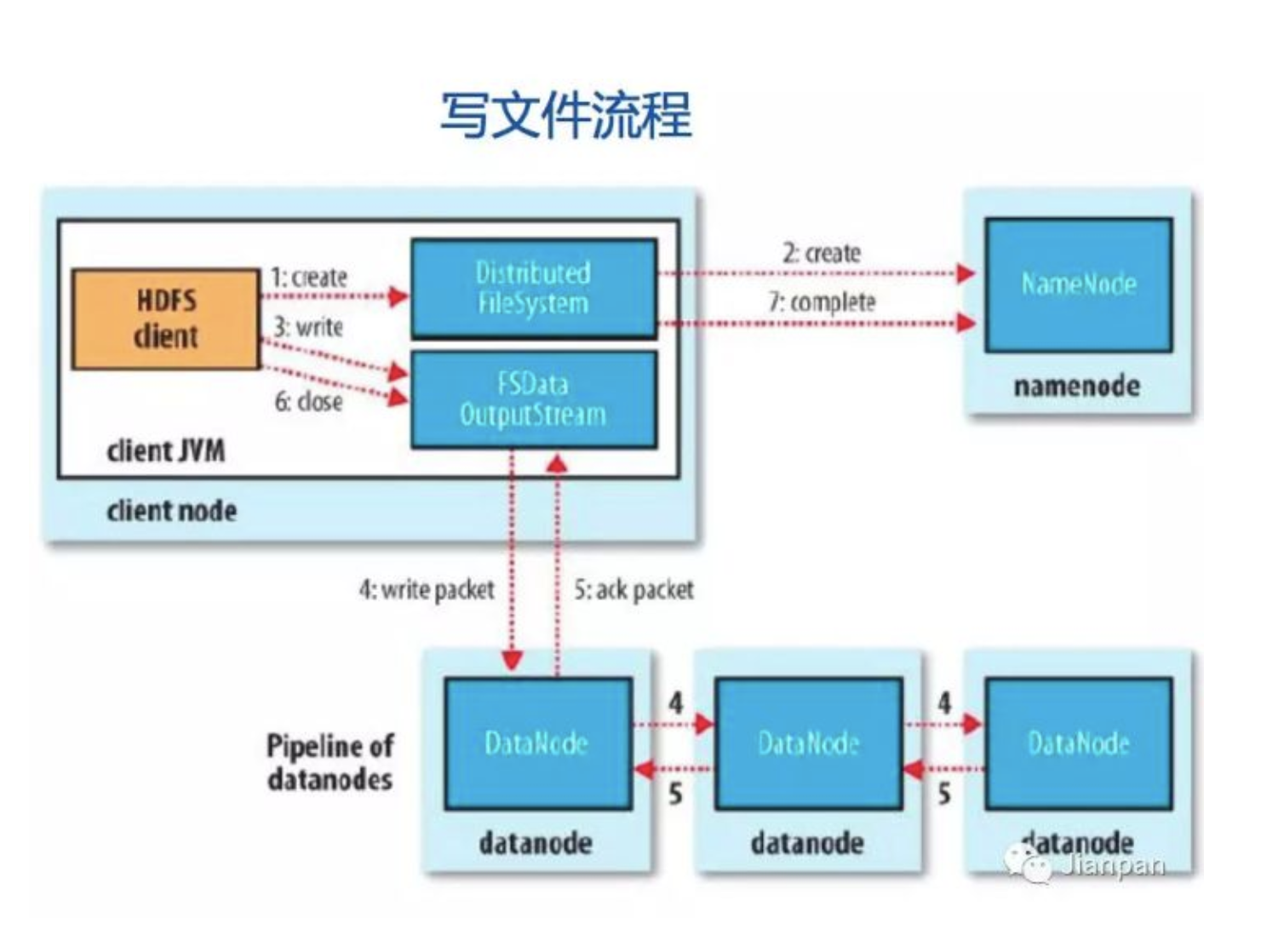

写文件流程

- 发送创建文件请求:调用分布式文件系统 DistributedFileSystem.create( )方法;

- NameNode 创建文件记录:分布式文件系统 DistributedFileSystem 发送 RPC 请求给 NameNode,NameNode 检查权限后创建一条记录,DistributedFileSystem 返回输出流 FSDataOutputStream,封装了输出流 DFSOutputDtream;

- 客户端写入数据:输出流 DFSOutputDtream 将数据分成一个个的数据包,并写入内部队列。DataStreamer 根据 DataNode 列表来要求 NameNode 分配适合的新块来存储数据备份。 一组 DataNode 构成管线(管线的 DataNode 之间使用 Socket 流式通信);

- 使用管线传输数据:DataStreamer 将数据包流式传输到管线第一个DataNode,第一个 DataNode 再传到第二个DataNode,直到完成;

- 确认队列:DataNode 收到数据后发送确认,管线的 DataNode 所有的确认组成一个确认队列。所有 DataNode 都确认,管线数据包删除;

- 关闭:客户端对数据量调用 close( ) 方法。将剩余所有数据写入DataNode管线,联系NameNode并且发送文件写入完成信息之前等待确认;

- NameNode确认

故障处理:若过程中发生故障,则先关闭管线,将ackQueue中的packet添加回dataQueue,确保数据包不漏。从管线中移除故障 DataNode,从 NameNode 中重新申请 DataNode 与原有的没有发生故障的 DataNode 组成新的管线。

重建管线时会将已经发送成功的packet从之前正常的 DataNode 上发送到新增加的 DataNode 上。接着生成新的 stamp 标识,并将该标识传送给 NameNode,

然后客户端跟管线构建连接后使用 stamp 标识更新 block,这样发生故障的 DataNode 上的错误 block 会在节点恢复正常后被 NameNode 删除。

在数据的读取过程中难免碰到网络故障,脏数据,DataNode 失效等问题,这些问题 HDFS 在设计的时候都早已考虑到了。下面来介绍一下数据损坏处理流程

- 当 DataNode 读取 block 的时候,它会计算 checksum。

- 如果计算后的 checksum,与 block 创建时值不一样,说明该 block 已经损坏。

- Client 读取其它 DataNode上的 block。

- NameNode 标记该块已经损坏,然后复制 block 达到预期设置的文件备份数 。

- DataNode 在其文件创建后验证其 checksum。

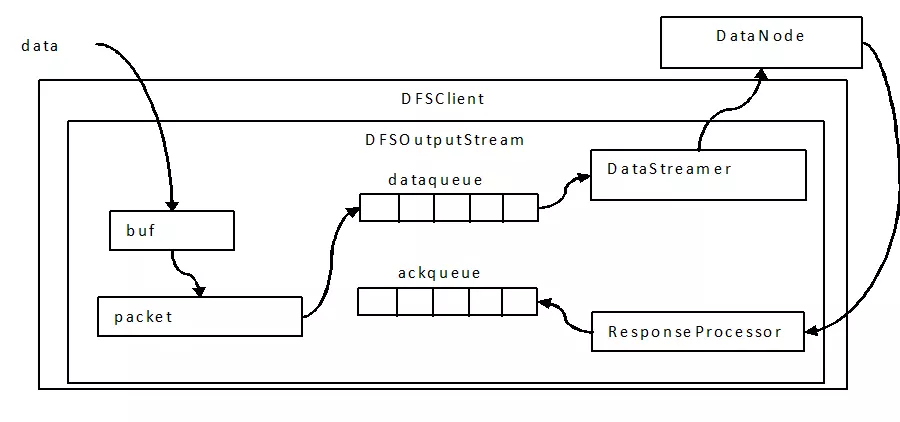

写过程中的三层buffer

写过程中会以chunk、packet及packet queue三个粒度做三层缓存;

首先,当数据流入DFSOutputStream时,DFSOutputStream内会有一个chunk大小的buf,当数据写满这个buf(或遇到强制flush),会计算checksum值,然后填塞进packet;

当一个chunk填塞进入packet后,仍然不会立即发送,而是累积到一个packet填满后,将这个packet放入dataqueue队列;

进入dataqueue队列的packet会被另一线程按序取出发送到datanode;(注:生产者消费者模型,阻塞生产者的条件是dataqueue与ackqueue之和超过一个block的packet上限)

参考链接